[트랜스포머] 트랜스포머 인코더를 이용한 시계열 예측.

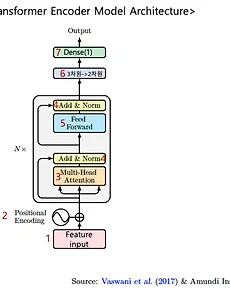

목표: 시계열 데이터를 트랜스포머 인코더를 이용하여 예측해보자. 전체코드: https://github.com/YongTaeIn/Transformer-Encoder-model-for-time-series.git 0. Input shape 의 변환 순서 1 번과정, embedding = [batch size, time_seq, feature_dim] 2번 과정, positional Encoding =[batch size, time_seq, d_model] 3번과정~4번과정Encoder blcok= [batch size, time_seq, d_model] 5번과정, FFW =[batch size, time_seq, 본인설정] 6번과정 ,차원축소=[batch size, time_seq] 7번과정, Dense =..

2023. 7. 13.

[트랜스포머] 트랜스포머 인코더를 이용한 시계열 예측.

목표: 시계열 데이터를 트랜스포머 인코더를 이용하여 예측해보자. 전체코드: https://github.com/YongTaeIn/Transformer-Encoder-model-for-time-series.git 0. Input shape 의 변환 순서 1 번과정, embedding = [batch size, time_seq, feature_dim] 2번 과정, positional Encoding =[batch size, time_seq, d_model] 3번과정~4번과정Encoder blcok= [batch size, time_seq, d_model] 5번과정, FFW =[batch size, time_seq, 본인설정] 6번과정 ,차원축소=[batch size, time_seq] 7번과정, Dense =..

2023. 7. 13.