0. Abstract

- 일본에서 자율주행한 17,785개의 데이터,

- 영상에 대한 captioning

- 특히 risk localization (위험지점 찾기), risk captioning (위험 설명)에 초점이 맞춰짐

1. Introduction

- 각각의 video_clip은 차량이 브레이크를 밟은 시점을 기준으로 인식한 위험을 묘사함.

- what, which, where, why, how 를 통합하여 caption을 만듬.

Contribution

- 중요객체와 관련된 위험에 대한 이유에 초점을 맞추어서 데이터 구성함.

- Caption 은 개방형 (답변이 정해져 있지 않은것, 자연어로 묘사등등..), 폐쇄형 데이터(미리 정의된 답변 구성이 있는것)로 구성됨.

- Risk lacalization에 맞춰진 캡션을 제공함, baseline benchmark 제공함.

2. Related work

- Important Object Identification : 모델이 결정한 것에 대한 추론 이유를 자연어 형태로 설명하지는 못하여 인간의 이해를 저해 및 방해함.

- Vision and Language Grounding : 우리의 목표는 특정한 객체를 기반으로 위험에 대한 캡션을 제공함.

- Datasets : 기존의 데이터셋은 risk localization에 초점이 맞춰지지 않음.

- BDD-X, BDD-OIA, HAD 가 캡션을 포함한 데이터이지만, risk를 인식하는것에 대해서 평가하기는 어렵다. (즉, ego 관점에서의 risk가 아니며 중요한 객체에 초점이 맞춰져있지 않음, label이 부족함)

→이를 해결하기 위해 DRAMA 데이터셋을 만듬.

- domain-specific vocabularies 로 캡션이 구성됨

- 왜 시나리오가 위험한지, 어떤 상호작용이 이루어지는지 보여주기 위해 만들어짐.

3. DRAMA Dataset (Figure 1참고)

- elementary operation (what, which, where, why, how) 은 represent object types, visual and motion attributes, object locations, or relationships of objects against the ego vehicle.

3.1 Dataset Creation (Figure 2참고)

- 브레이크를 밟았을때, 2초 동안 수집함. 17,785개의 드라이빙 시나리오가 만들어짐.

- 캡션을 ego의 motion에 직/간접적으로 만듬.

Video-level Q/A

- Risk, ego-car intention, scene classifier, Suggestions 로 4가지 질문의 속성을 나눔.

Object-level Q/A

- What, which, where, why, how 로 질문함으로 free-form, open-ended 응답을 하게함.

- Visual reasoning의 요소들 : querying object types (what), visual and motion attributes (which), location and motion direction (where), reasoning about risks or description of interactions (why), and effect of relationships (how).

3.2 Dataset Statistics (Figure 3a,b참고)

Video-level Q/A 는 아래와 같이 4종류가 있음.(Fig 3a)

- Risk (yes,no)

- Ego car intention (Straight, Left, Right)

- Scene classifier (Intersection, Narrow Road, Urban Road)

- Suggestion

Object-level Q/A에 대한 데이터 statistics .(Fig 3b)

3.3 Dataset Analysis (Table 1참고)

- 기존의 데이터셋과 차이를 보여줌.

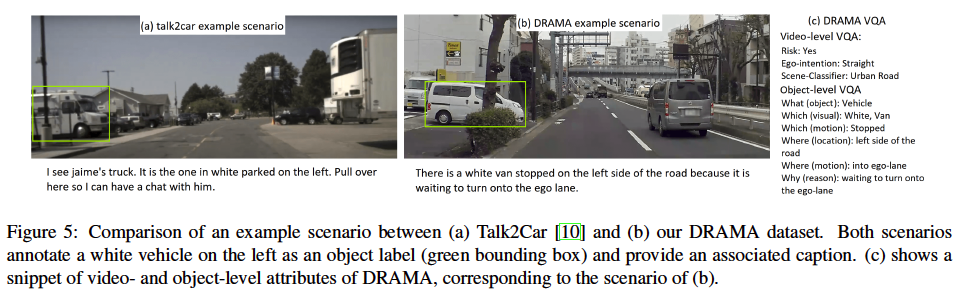

- T2C와 DRAMA 데이터셋의 차이를 보여줌. Figure 5

4. Methodology (Figure 6)

- Encoder:

I : ResNet-101 사용, t시점의 이미지 (I_t 이미지 사용)

F : Flownet 2.0 사용(=OF) , t시점의 이미지, t-1 시점의 이미지 (이미지 2개사용)

(OF=optical flow)

-Decoder :

LSTM, Self Attention을 통해 만듬 ( = SAT[ref1] 라는 논문꺼 사용함)

(ref1 : 논문명 : Show, attend and tell: Neural image caption generation with visual attention.)

- Loss Function

Risk localization loss 와 Caption loss 를 연결해서 사용함

5. Experiments

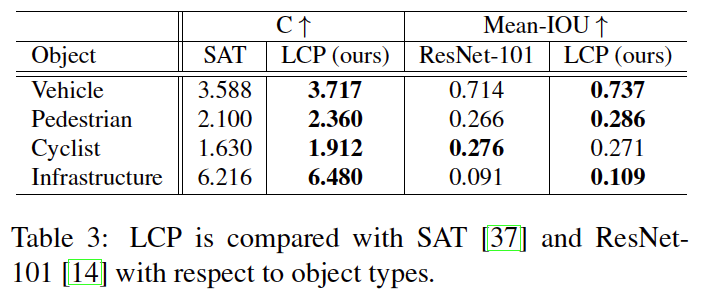

5.1 Model Comparion

- resnet-101

- SAT : show attention and tell

- ICL (Independent Captioning and Localization) : 이 모델은 위험 로컬라이제이션과 캡션 생성을 독립적으로 수행함.

- LCP (Localization with Captioning Prior) : 이 모델은 캡션 생성을 로컬라이제이션에 사용하는 prior로 활용함. 즉, 로컬라이제이션 작업이 캡션 생성을 돕도록 설계되어 있음. LCP는 로컬라이제이션 정보(객체의 위치 등)를 사용하여 더 나은 캡션을 생성하도록 훈련됨.

5.2 Experimental Setting and Metrics

- Captioning 평가 : BLEU-1 (B1), BLEU-4 (B4), METEOR (M), ROGUE (R), CIDER (C), and SPICE (S)

- Bounding box 평가 : Mean-IOU (Intersection Over Union), accuracy for IOU>0.5

5.3 Results (Figure7, Table2, Table3)